Uso óptimo y responsable de la inteligencia artificial

¿Qué hacer ante la realidad de la llegada de la inteligencia artificial a las escuelas? En el marco del SIEI 2025, organizado por la Fundación SM en México, el director de SMART Philosophy ofrece pautas para alinear la inteligencia artificial (IA) con los objetivos educativos, y propone algunos usos óptimos de la IA en la escuela.

Durante cinco años, un grupo de filósofos, ingenieros y algunos abogados nos hemos dedicado a “resistir” a la tecnología, pero resistir es primero entenderla. Resistir es hacer alianzas tecnológicas y filosóficas, como la comunidad EurekAI, en la que ingenieros, abogados y filósofos debatimos sobre la IA.

Esa resistencia hoy es un diferenciador en los colegios. Ya casi cualquier colegio puede usar IA generativa, pero el diferenciador no es eso, sino en qué medida la utilizas con los profesores correctos y con las tareas correctas. Ahí es donde viene el problema de la alineación. En este tema, entra la filosofía y se mete a cuestionar a la tecnología: ¿está alineada en lo que queremos los seres humanos o vamos a meter tecnología con calzador en la educación y la vamos a dañar más? Aquí la alineación se ejemplifica con el problema del genio: “Genio, quiero medir 1,90 y yo mido uno 1,80”. El genio, que es chat GPT o algún motor más complejo, me hace medir 1,90 pero alargándome la cabeza.

En los ecosistemas educativos no puedes optimizar solo unas partes esperando que todo el organismo funcione bien, porque lo echas a perder, lo lastimas. Esa es la alineación. Debes tener cuidado de qué estás optimizando para no lastimar el sistema, porque la educación es florecimiento.

Los docentes no van a ser reemplazados por la IA. El profesor es irremplazable; primero, porque la IA se equivoca, alucina; segundo, porque la IA no te va a acompañar en la seguridad que tiene un profesor. Sí puede subsanar o compensar en comunidades donde no hay profesores capacitados, pero no sustituir, porque el ser humano es un ente vivo y tiene que florecer. No podemos optimizar solo una variable porque la echamos a perder.

Amenaza para el pensamiento crítico

Un artículo reciente, de investigadores de Carnegie Mellon University y de Microsoft, muestra muy claramente un declive en el pensamiento crítico por el uso cotidiano de la IA generativa.

Cualquier profesor y persona sensata sabe que si delegas la capacidad de pensamiento creativo es como si dejas de entrenar un músculo, se debilita. No es rocket science. Al estar delegando las búsquedas, por ejemplo, a motores de recomendación, los niños están perdiendo uno de los ejercicios intelectuales más importantes, que es buscar lo que les gusta, buscar un interés propio, y eso se lo están delegando a un algoritmo de recomendación. TikTok te dice lo que te gusta sin hacer el esfuerzo por buscarlo.

Este es un tema más triste. Financial Times y otros medios renombrados observaron a partir de los datos de lectoescritura, de pensamiento numérico y crítico, un declive muy claro en la inteligencia en el siglo xxi. La capacidad de los alumnos de prestar atención sostenida frente a un problema es ya una evidencia, porque estamos optimizando, pero a la vez estamos perdiendo la visión panorámica. Estamos optimizando el hecho de que el alumno tenga un tutor personalizado como un chat GPT entrenado para tu colegio. Sí, pero también estamos olvidando que somos animales sociales por naturaleza. Una de las mayores enfermedades es el aislamiento. El Surgeon General, la máxima autoridad sanitaria de Estados Unidos, lo llama epidemia de soledad. Lo acuñó así en 2023. Esta epidemia de soledad hace que emerjan enfermedades psicológicas que llevan a comportamientos disruptivos. Somos sociables, pero si aíslan al chico y un algoritmo de recomendación le dice que quizá pueda gustarle cierto grupo que resulta ser reclutamiento para Isis, o Al Qaeda, o el narcotráfico mexicano, o grupos extremistas de izquierda y de derecha, entonces, el lugar de más intimidad y de más seguridad, que era la habitación de tu hijo o de tu alumno, se volvió el lugar de mayor riesgo. Ahí es donde no queremos optimizar por optimizar, porque estamos aislando a nuestros alumnos.

Un caso aislado, que también hay que mencionar, es que muchos de nuestros alumnos no perciben todavía la diferencia entre la realidad y la ficción, por eso, lo importante no es quién va a usar la IA y cuándo, sino cuándo no conviene usar la IA. Es la primera pregunta de higiene educativa. A qué edad no conviene que estén expuestas las infancias, porque todavía no distinguen. Esto solamente es un llamado a los directores y profesores a que entendamos que la IA, si bien es necesaria e inevitable y tenemos que convivir con ella, con su arrogancia, en la medida en que hagamos alianza nos va a explicar cómo funcionan sus “juguetes” para poder utilizarlos para el florecimiento en la educación, y no solo optimizar ciertas variables.

Usos óptimos de la IA

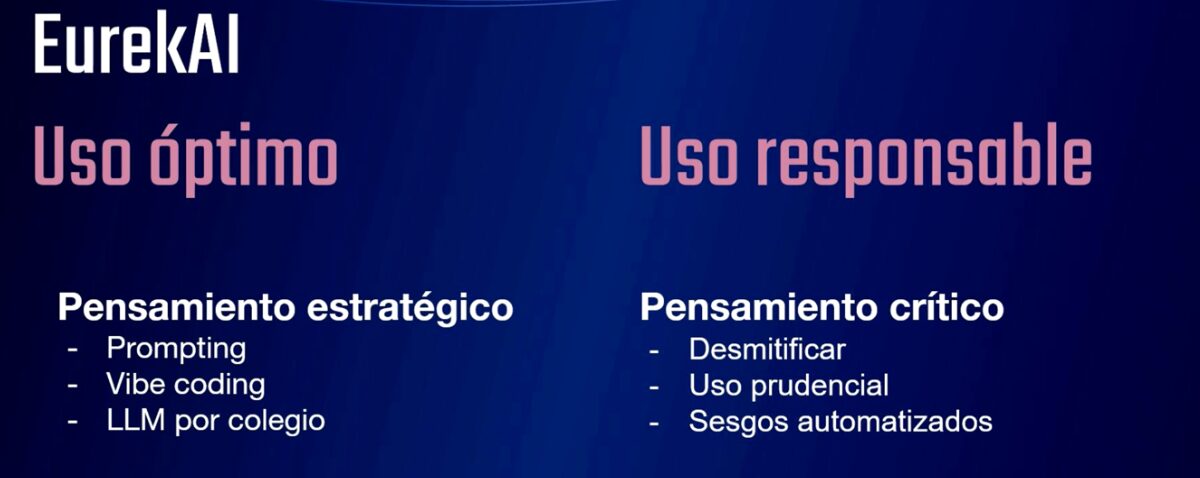

Lo diferencial para una escuela va a ser el uso ético, responsable -ahora sí, inteligente en la visión más orgánica y ecosistémica- de la IA. El pensamiento estratégico y el pensamiento crítico van a permitir eso. Cuando tenemos un plan de estudios para un alumno, lo primero que buscamos es que desmitifique la IA, que vea qué sí y qué no es y, en el camino, que vea cómo las matemáticas y la programación fueron lo que le permitieron tener esa capacidad.

Lo primero que queremos es reivindicar las matemáticas y la programación en este país donde, según la ocde, tenemos unos niveles de pensamiento lógico muy bajos, comparados con los de otros países. Queremos que vean que toda esa maravilla que pueden lograr se debe a un “gimnasio” intelectual, algo así como levantar pesas de matemáticas. Eso es la desmitificación. Al final es mucho trabajo intelectual.

En segundo lugar, separar lo que sí es realidad de lo que es ficción, sobre todo en primaria y secundaria. Que no nos pase que ese alumno más aislado empiece a recargarse emocional, afectiva y socialmente en una máquina. Eso no nos puede pasar a nosotros en este ecosistema educativo.

También está el uso prudencial: cuándo sí y cuándo no. Hace un momento yo decía que es inevitable, pero tenemos la capacidad de imaginar alternativas, mundos posibles donde no sea necesario que el alumno tenga una pantalla. Creo que es fundamental ganarle espacios a la sociabilidad. En ese uso prudencial se verá cómo ganamos espacios y empujamos a la tecnología.

Por último, cómo entrenamos a los alumnos en pensamiento crítico para que reconozcan sus propios sesgos a la hora de hacer preguntas, de buscar resultados, pero también identificar los sesgos de la herramienta. Qué atajos toma la herramienta cuando le pido una imagen, porque tiene sesgos.

Es algo de alfabetización que nos interesa hacer con este proyecto EurekAI que he mencionado antes:

Los participantes en esta comunidad nos dedicamos a la alfabetización digital, que es un objetivo básico, sobre todo en un país donde los alumnos no tienen un blindaje frente a las compañías y las tecnologías, porque no hay ese mínimo de alfabetización digital necesario.

Enrique Siqueiros es director de SMART Philosophy y cofundador de EurekAI.

Referencia

- Hao-Ping (Hank) Lee, Advait Sarkar, Lev Tankelevitch, Ian Drosos, Sean Rintel, Richard Banks, and Nicholas Wilson (2025). The Impact of Generative AI on Critical Thinking: Self-Reported Reductions in Cognitive Effort and Confidence Effects From a Survey of Knowledge Workers. In CHI Conference on Human Factors in Computing Systems (CHI ’25), April 26–May 01, 2025, Yokohama, Japan. ACM, New York, NY, USA, 23 pages. https://doi.org/10.1145/3706598.3713778